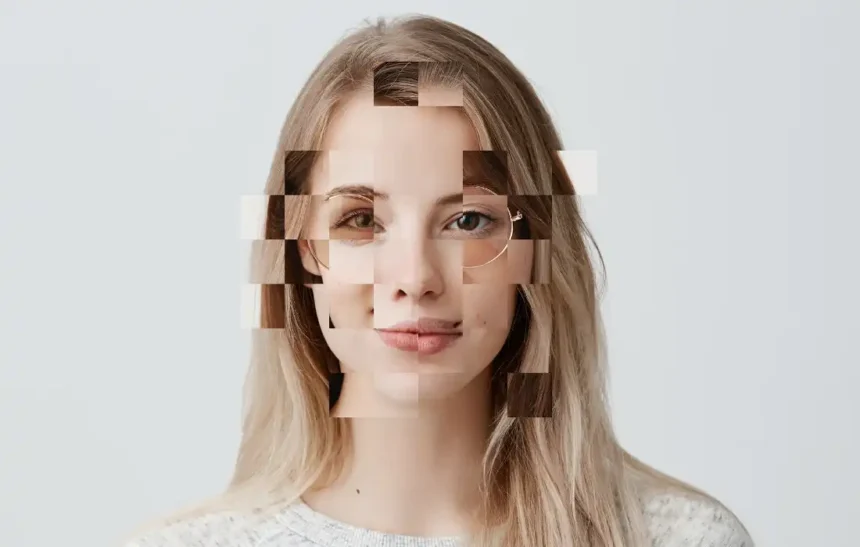

Oggi, 10 ottobre 2025, entra in vigore la legge italiana sull’AI. Un aspetto particolarmente rilevante di questa nuova legislazione riguarda la regolamentazione che introduce il reato di deepfake, una tecnologia che, se utilizzata in modo improprio, può avere conseguenze devastanti sulla reputazione delle persone, sulla disinformazione e sulla fiducia nel sistema informativo.

Deepfake: cosa sono e perché preoccupano

I deepfake sono contenuti multimediali (immagini, video, audio) creati o manipolati utilizzando tecniche di intelligenza artificiale, in particolare il deep learning. Questi contenuti possono essere utilizzati per sovrapporre il volto di una persona a un corpo diverso, per far dire a una persona cose che non ha mai detto, o per creare eventi che non sono mai accaduti. La loro crescente sofisticazione rende sempre più difficile distinguerli dai contenuti autentici, aprendo la strada a utilizzi fraudolenti e dannosi.

Come riporta Repubblica.it, “la facilità con cui si possono creare deepfake sempre più credibili rende questa tecnologia un’arma potente per la disinformazione e la diffamazione”. Il rischio è che i deepfake vengano utilizzati per diffondere notizie false, manipolare l’opinione pubblica, danneggiare la reputazione di persone o aziende, o addirittura per commettere frodi e reati. La legge italiana sull’AI cerca di rispondere a queste preoccupazioni, introducendo nuove norme e sanzioni per contrastare l’utilizzo improprio di questa tecnologia.

Il deepfake diventa reato: cosa cambia con la nuova legge

Una delle principali novità introdotte dalla legge italiana sull’AI è la creazione del reato di deepfake, come riportato da Il Sole 24 Ore. La norma punisce chiunque diffonda, con qualsiasi mezzo, contenuti deepfake idonei a ledere la reputazione, l’onore o il decoro di una persona, a ingannare il pubblico o a turbare l’ordine pubblico. Le pene previste variano a seconda della gravità del reato, ma possono arrivare fino a diversi anni di reclusione e a sanzioni pecuniarie elevate.

Fanpage spiega invece che “La legge non si limita a punire la creazione di deepfake, ma anche la loro diffusione, riconoscendo che il danno maggiore deriva spesso dalla viralità dei contenuti manipolati. Questo significa che anche chi condivide un deepfake senza esserne l’autore può essere ritenuto responsabile, se è consapevole della sua natura manipolata e del suo potenziale dannoso.”

Aggravanti e circostanze attenuanti

La legge prevede una serie di circostanze aggravanti che comportano un aumento delle pene per il reato di deepfake. Ad esempio, la pena è più severa se il deepfake riguarda una persona minorenne, una persona con disabilità, una persona in stato di vulnerabilità, o una figura pubblica (es. politico, giornalista, artista). La pena è inoltre aumentata se il deepfake viene utilizzato per influenzare il risultato di elezioni o referendum, per commettere frodi o per incitare all’odio o alla violenza.

Al contrario, la legge prevede alcune circostanze attenuanti che possono comportare una riduzione delle pene. Ad esempio, la pena può essere ridotta se l’autore del deepfake dimostra di aver agito in buona fede, senza l’intento di arrecare danno, o se si adopera per rimuovere tempestivamente il contenuto manipolato una volta scoperta la sua natura non autentica.

L’obbligo di trasparenza

Oltre a introdurre il reato di deepfake, la legge italiana sull’AI prevede una serie di misure per promuovere la trasparenza e la responsabilità nell’utilizzo di questa tecnologia. In particolare, la legge impone ai fornitori di servizi online (es. social network, piattaforme di video sharing) di adottare misure tecniche e organizzative per identificare e segnalare i contenuti deepfake, per informare gli utenti sulla loro natura manipolata e per facilitarne la rimozione.

La legge prevede inoltre l’obbligo per i creatori di contenuti deepfake di indicare chiaramente che il contenuto è stato generato o manipolato con l’AI. Questa informazione deve essere visibile in modo chiaro e facilmente accessibile agli utenti, per consentire loro di valutare criticamente il contenuto e di non essere ingannati.

Il ruolo dell’agenzia nazionale per l’AI

L’Agenzia Nazionale per l’AI, istituita dalla legge, ha un ruolo centrale nella lotta contro i deepfake. L’agenzia ha il compito di monitorare l’evoluzione tecnologica dei deepfake, di promuovere la ricerca e lo sviluppo di strumenti per la loro identificazione e contrasto, di sensibilizzare il pubblico sui rischi e le opportunità di questa tecnologia e di coordinare le attività delle diverse autorità competenti (es. polizia postale, autorità per le comunicazioni).

L’agenzia ha inoltre il potere di adottare linee guida e raccomandazioni per i fornitori di servizi online e per i creatori di contenuti deepfake, per promuovere l’adozione di buone pratiche e per prevenire utilizzi impropri della tecnologia.

Il confronto con la legislazione europea

La legge italiana sull’AI si inserisce in un contesto europeo in cui la regolamentazione del reato di deepfake è ancora in fase di sviluppo. L’AI Act, pur non affrontando specificamente la questione dei deepfake, prevede una serie di disposizioni che possono essere applicate anche a questi contenuti, in particolare quelle relative alla trasparenza, all’accuratezza e alla non-discriminazione dei sistemi di IA. In futuro, è probabile che l’UE adotti una normativa più specifica sui deepfake, che potrebbe prevedere obblighi più stringenti per i fornitori di servizi online e per i creatori di contenuti manipolati.

Alcuni paesi europei hanno già adottato leggi o regolamenti specifici sui deepfake, come la Germania, che ha introdotto l’obbligo di etichettare i contenuti generati con l’IA, o la Francia, che ha previsto sanzioni per la diffusione di deepfake a scopo politico. La legge italiana si allinea a questa tendenza, ma si distingue per la creazione di un reato specifico, che punisce la diffusione di contenuti deepfake dannosi.

Le sfide future

La lotta contro il reato di deepfake è una sfida complessa e in continua evoluzione. Le tecnologie di manipolazione dei contenuti sono sempre più sofisticate, e diventa sempre più difficile distinguerle dai contenuti autentici. La legge italiana sull’AI rappresenta un passo importante in questa direzione, ma è necessario un impegno costante per monitorare l’evoluzione tecnologica, per aggiornare le norme e per sensibilizzare il pubblico sui rischi e le opportunità di questa tecnologia.

Sarà inoltre fondamentale promuovere la cooperazione internazionale per contrastare la diffusione di deepfake provenienti da paesi terzi e per armonizzare le legislazioni a livello globale. Solo con un approccio coordinato e multilaterale sarà possibile affrontare efficacemente questa sfida e garantire un futuro digitale sicuro e affidabile.